stm32并行

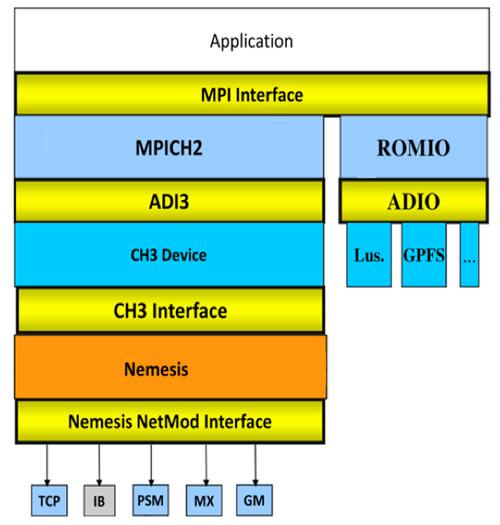

STLMPi并行编程是一种高效、易用、可移植且可扩展的并行编程方式,通过结合MPI和STL可以方便地编写并行程序,并充分利用计算资源进行并行计算。在实际应用中,可以根据具体问题的需求合理地使用STLMPi并行编程,并遵循最佳实践以提高程序的性能和可维护性。

std::cout << std::endl;

std::vector

int main(int argc, char** argv) {

MPI_Comm_rank(MPI_COMM_WORLD, &rank);

local_data.push_back(rank * 10 i);

MPI_Allgather(local_data.data(), 10, MPI_INT, global_data.data(), 10, MPI_INT, MPI_COMM_WORLD);

MPI_Finalize();

MPI_Comm_size(MPI_COMM_WORLD, &size);

在进行STLMPi并行编程时,有几个最佳实践可以帮助提高程序的性能和可维护性:

for (int i = 0; i < 10; i) {

std::cout << global_data[i] << " ";

if (rank == 0) {

下面是一个使用STLMPi进行并行编程的简单示例:

在这个示例中,每个进程生成一些本地数据,然后使用MPI_Allgather函数将所有进程的数据收集到一个全局数组中,最后由rank为0的进程输出全局数据。

STLMPi并行编程

include

include

for (int i = 0; i < size * 10; i) {

std::vector

}

// 使用MPI的通信函数进行数据交换

include

```cpp

// 输出全局数据

return 0;

int rank, size;

```

MPI_Init(&argc, &argv);

}

}

}

STLMPi并行编程是指在并行计算中使用MPI(Message Passing Interface)库与STL(Standard Template Library)结合的编程方式。MPI是一种用于编写并行程序的消息传递标准,而STL是C 语言的标准模板库,提供了丰富的数据结构和算法。将两者结合使用可以更方便地编写并行程序,提高程序的效率和可维护性。

// 每个进程生成一些数据

STLMPi结合了MPI和STL的优点,具有以下优势: